ChatGPTが非常に注目を集めています。毎日ChatGPTに関する何らかのニュースを見る日々が続いています。

www.patent-topics-explorer.com

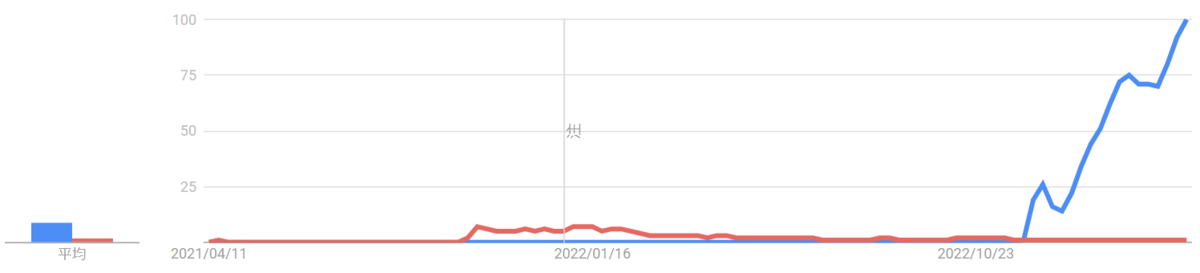

実際、Googleトレンドで最近政府が注目しているメタバースとのトレンドの差を見ても、ChatGPTの圧倒的なトレンドが伺えます。

過去3年間のChatGPT(青)とMetaverse(赤)のグローバルでのGoogleトレンド検索結果

検索の代替と文章生成能力に期待して、今回特許出願の背景技術部分が書けるか実験してみました。お願いした条件は大体下記の感じです。

今回の発明: トランスフォーマーアルゴリズムを用いた専門知識を有するチャットボットの発明。

背景技術: ですます調は用いない。

非特許文献: 日本の非特許文献の記載に合わせる。簡単な要約をつける。

ここで、特許文献は何故出力しないかですが、特許文献は架空の文献が出力されることが多くあきらめたというのが実情です。論文と違って、特許文献はUS1,234,567Bのように数字で特定しており、文献の内容と割り振られた番号には何の関係もないので、ChatGPTは自然言語処理のアルゴリズムを用いているので厳しいのかもしれません。

まず、従来版のGPT-3.5バージョンのChatGPTです。

GPT-3.5 (通常)

【背景技術】 チャットボットは、自然言語処理技術を用いて人工知能によって作成されたプログラムであり、ユーザーと対話することができます。従来のチャットボットは、ルールベースの手法や統計的手法を使用しており、ユーザーの入力を認識して適切な応答を返すことができますが、専門知識を持つチャットボットの作成には限界があります。そこで、トランスフォーマーアルゴリズムを用いた専門知識を持つチャットボットが開発されました。トランスフォーマーアルゴリズムは、自然言語処理タスクにおいて優れた性能を発揮し、専門的な知識を持つチャットボットの開発に有用な技術となっています。

【非特許文献】

【非特許文献1】 A. Vaswaniらによる「Attention Is All You Need」という論文は、トランスフォーマーアルゴリズムの提案を行いました。このアルゴリズムは、従来のリカレントニューラルネットワークや畳み込みニューラルネットワークに比べ、長距離の依存関係を扱うことができます。トランスフォーマーは、自然言語処理において、様々なタスクにおいてSOTA(state-of-the-art)の性能を発揮しています。

【非特許文献2】 A. Conneauらによる「Unsupervised Cross-lingual Representation Learning at Scale」は、トランスフォーマーアルゴリズムを用いた多言語の文書埋め込み表現の獲得方法を提案しています。この手法は、異なる言語間での知識の転移を可能にするため、多言語チャットボットの開発に役立つことが期待されています。

そこそこな感じもしますが、ですます調を使うなというお願いや、論文の名前の書き方を日本特許庁の形式に合わせてほしいというお願いは何度もやっても聞いてもらえないことが多かったです。

さて、そこで課金してGPT-4での生成を試みてみます。出力結果は下記でした。

GPT-4 (課金バージョン)

【背景技術】 トランスフォーマーアルゴリズムを用いた専門知識を有するチャットボット技術は、近年急速に発展している。従来の技術においては、専門知識の習得に時間がかかり、多様な応答が難しいという課題があった。例えば、Vaswaniらにより提案されたAttention Is All You Need (非特許文献1参照)は、トランスフォーマーアルゴリズムの基礎を築き、自然言語処理の精度向上を図るために開発された。しかし、このアルゴリズムは専門知識の習得やチャットボットへの応用に関しては限定的であった。

【非特許文献】

【非特許文献1】Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., ... & Polosukhin, I. (2017). Attention is all you need. In Advances in Neural Information Processing Systems (NIPS), United States, Curran Associates, Inc., 2017年12月, 30, pp. 5998-6008.

まず、GPT-3.5のときと異なり、ですます調を使うなというお願いや、論文の名前の書き方を日本特許庁の形式に合わせてほしいというお願いも比較的に聞いてもらえます。また、背景技術の箇所に(非特許文献1参照)のように引用箇所も提示するようにしたお願いも反映した記載になりました。

GPT-4はGPT-3.5に比べて、質問文(プロンプト)でこの条件は守ってほしいと指示した内容は比較的拾ってくれるので、プロンプトエンジニアリングの重要性が更に増している印象を持ちました。よりよい文章を出すならばそちらの検討をしても面白いかもしれません。

もう一つは、間違いを指摘したり、自己批判をさせると回答が向上する印象がありました。ここら辺も使うとよいかもしれません。

一方で、特許文献より割合は少なくはなるものの、非特許文献でも誤情報は一定の割合で出てきました(少なくとも私の質問文では)。やはり、生成された文章の裏取りは常に必要だなという印象でした。

関連: Web Browser機能で再度挑戦編

www.patent-topics-explorer.com

関連: Google Bardで再度挑戦編

www.patent-topics-explorer.com